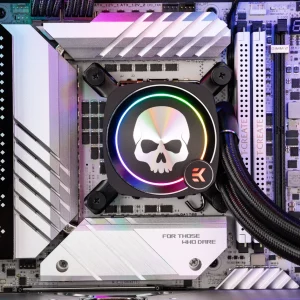

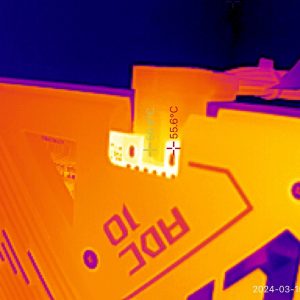

10 Wasserblöcke je 2 Plattformen je 2 Pumpen-Einstellungen, mit jeweils verschiedenen Montage-Varianten, haben wir im heutigen Artikel für euch getestet. Dabei geht es nicht um theoretische Werte, sondern um echte Performance-Zahlen, die auch jeder Leser bei sich zu Hause mit etwas Aufwand so nachmessen kann. Hintergrund des Ganzen ist natürlich [...]

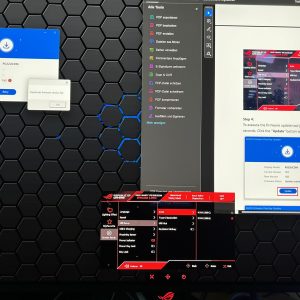

Wer steckt eigentlich hinter der PCI SIG und der PCI Express Normierung?