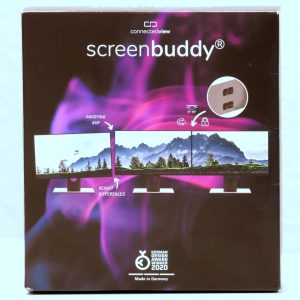

Verpackung und Lieferumfang Für den Fall, dass man zwischen Kauf und Erhalt der NAS vergessen hat, wer sie hergestellt hat, wird der Name nochmal auf jeder Seite des Kartons aufgedruckt. Sehr hilfreich! Der Inhalt wird durch passend zugeschnittene Blöcke aus Schaumstoff geschützt, seitlich befindet sich noch zusätzlich eine Box mit dem Zubehör [...]

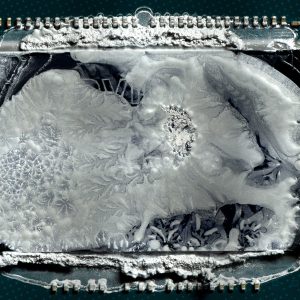

Einfach abgezogen! Neuer Wärmeleitpasten-Applikator X-Apply aus der Community im Praxis-Test